相关文件下载

Ollama安装包+Docker安装包:本地部署DeepSeek(自定义盘符安装+构建可视化)资源.zip

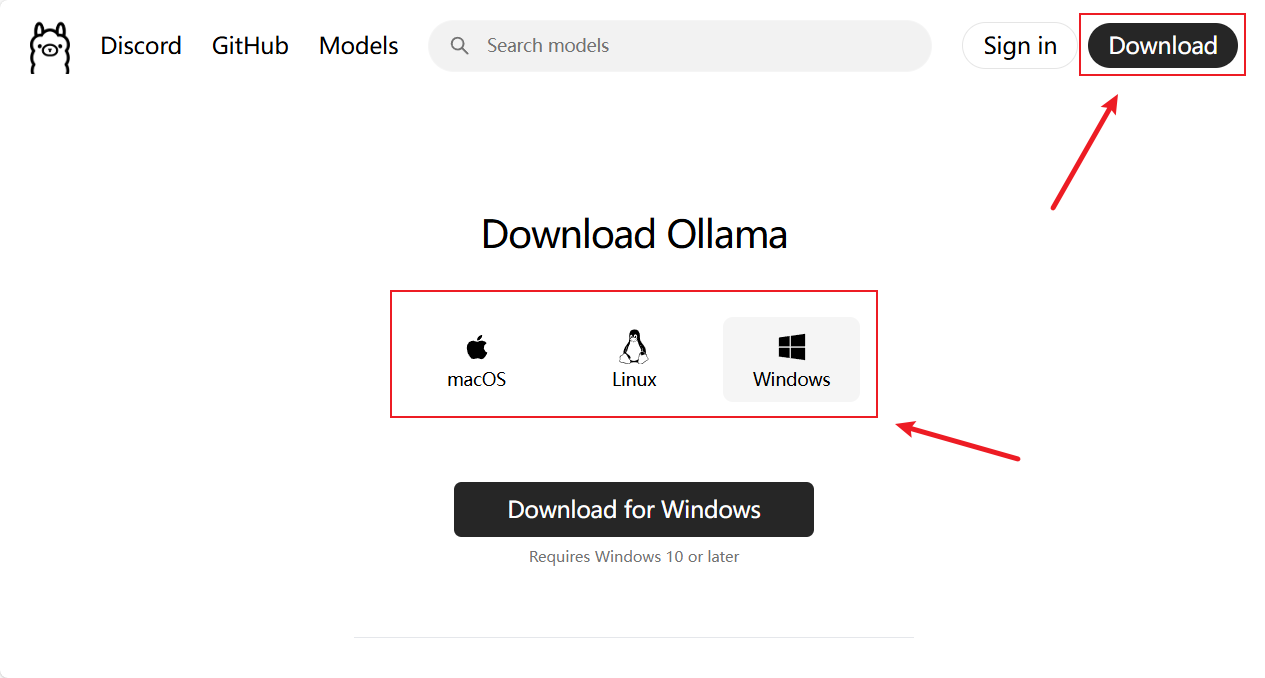

1.Ollama安装(自定义盘符安装)

(1)官网下载:(Ollama)

- 这里以Windows版本为例(自定义盘符安装,默认是C盘)

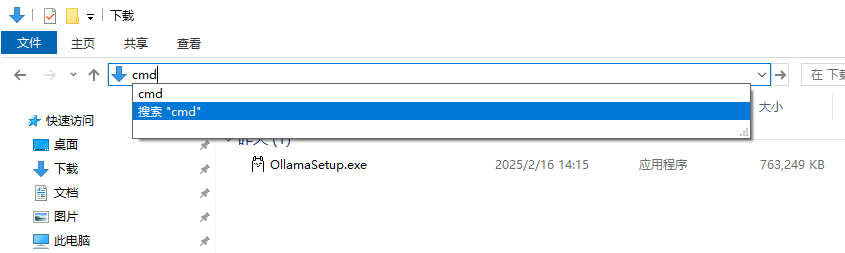

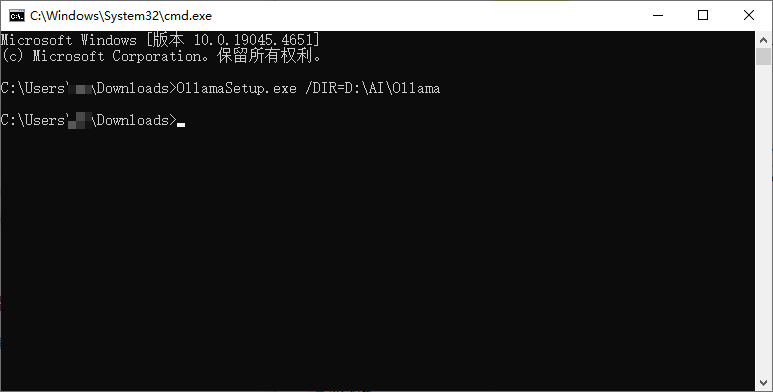

下载完成后在搜索栏输入cmd打开终端窗口,输入以下代码:

OllamaSetup.exe /DIR=D:\AI\Ollama参数说明

- OllamaSetup.exe:安装程序执行文件

- /DIR=路径地址:命令参数,指定安装目录。

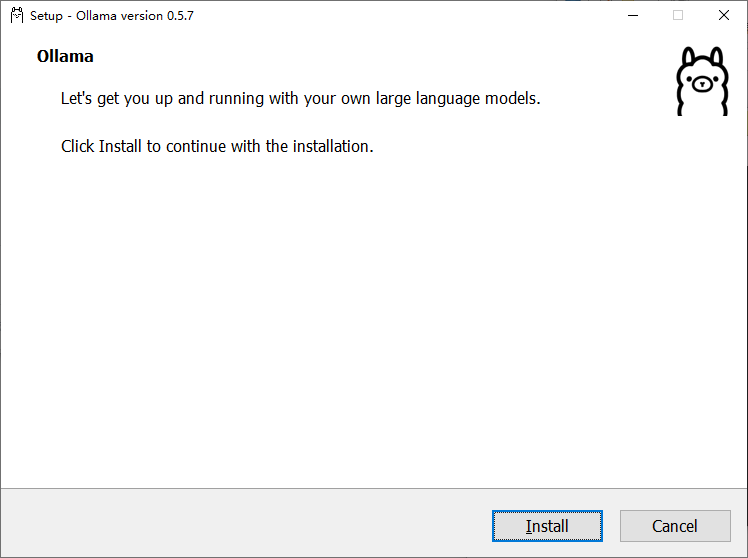

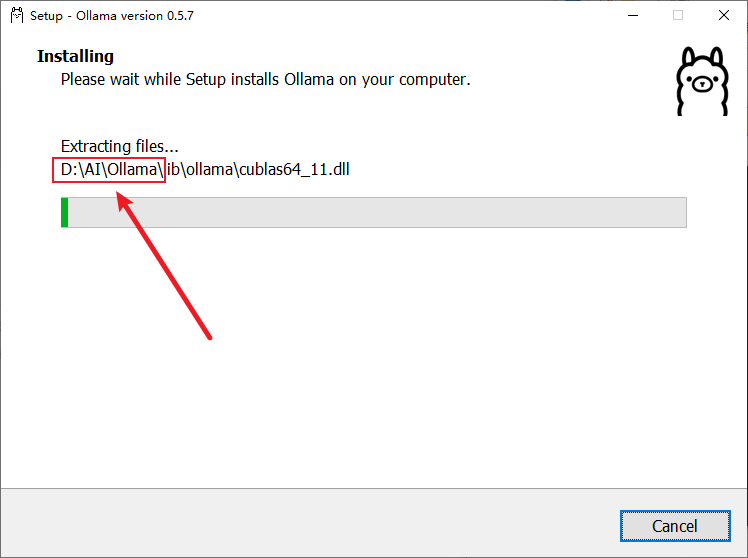

执行完命令后点击Install进行下载后即可以看到安装路径为自定的路径。

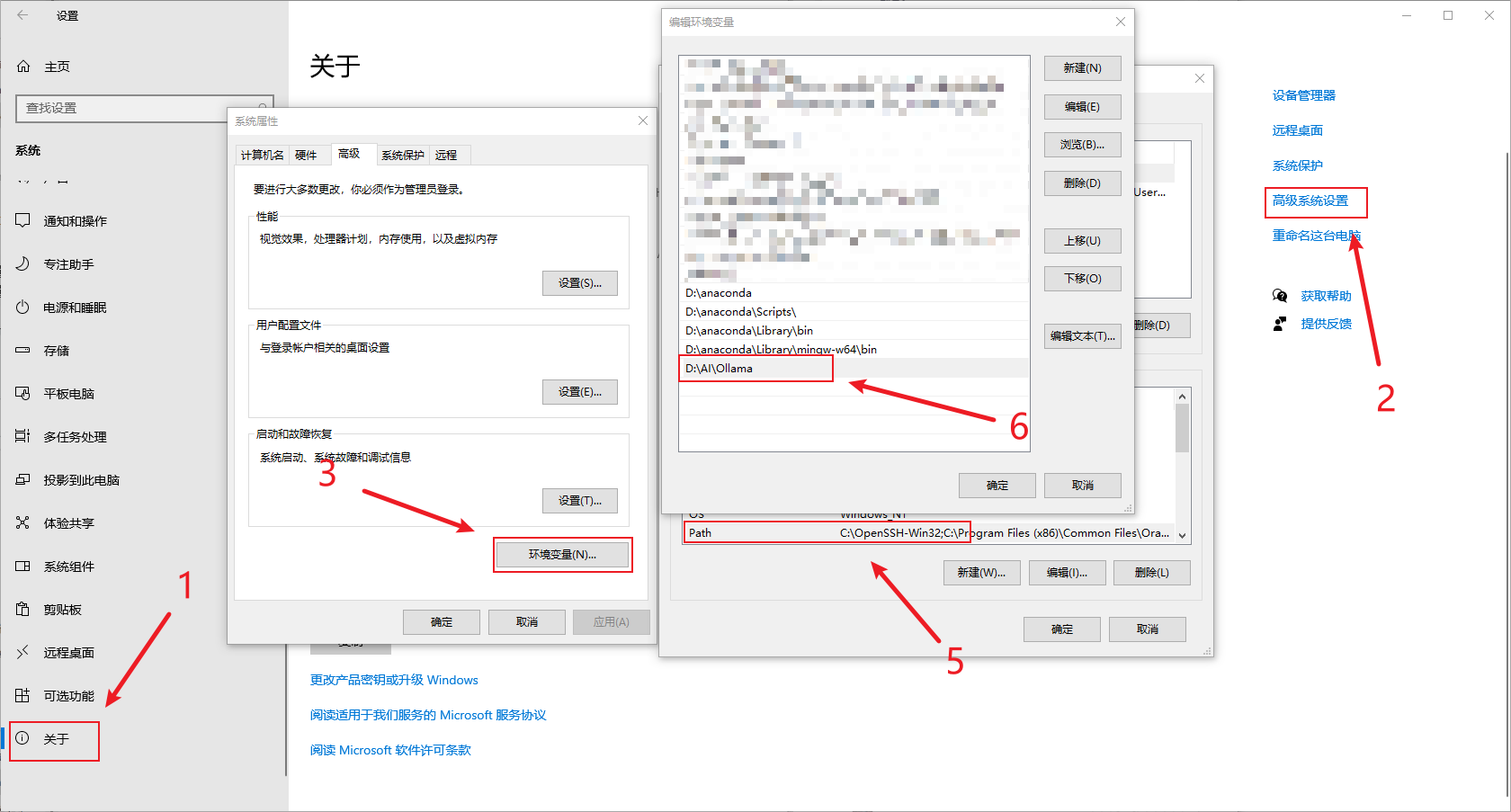

(2)添加环境变量

- 添加PATH

D:\AI\Ollama

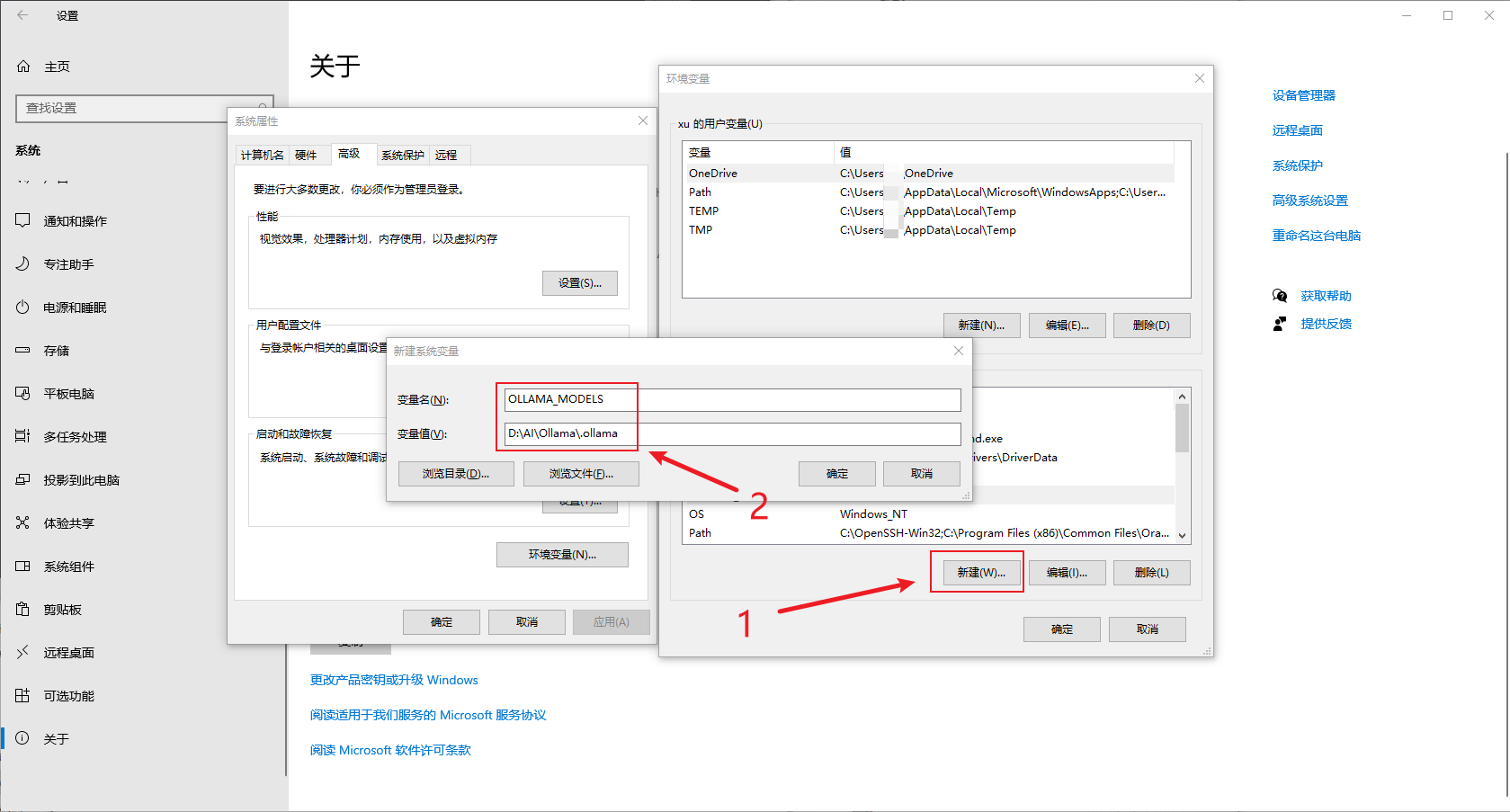

- 添加系统变量

变量名:OLLAMA_MODELS

变量值:D:\AI\Ollama\.ollama

(3)刷新环境变量

方法一:重启

方法二:命令行窗口代码执行

taskkill /f /im Explorer.exe && start Explorer.exe参数说明

- taskkill:结束指定进程。

- /f:命令参数,表示强制结束进程

- /im 进程名称:命令参数,指定进程的名称

- &&:命令链接符

- start 进程名称:启动进程

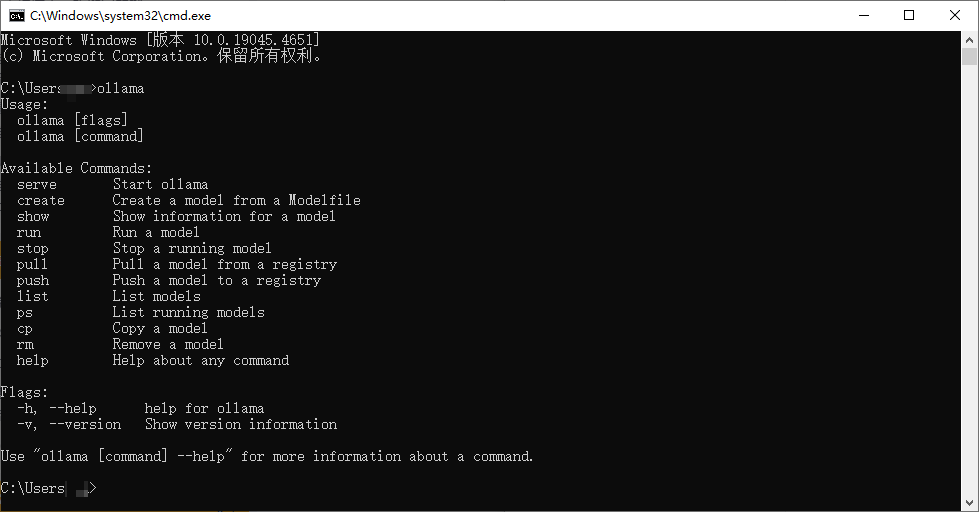

测试环境

命令行窗口代码执行以下代码运行如下即可代表成功

ollama

2.模型下载

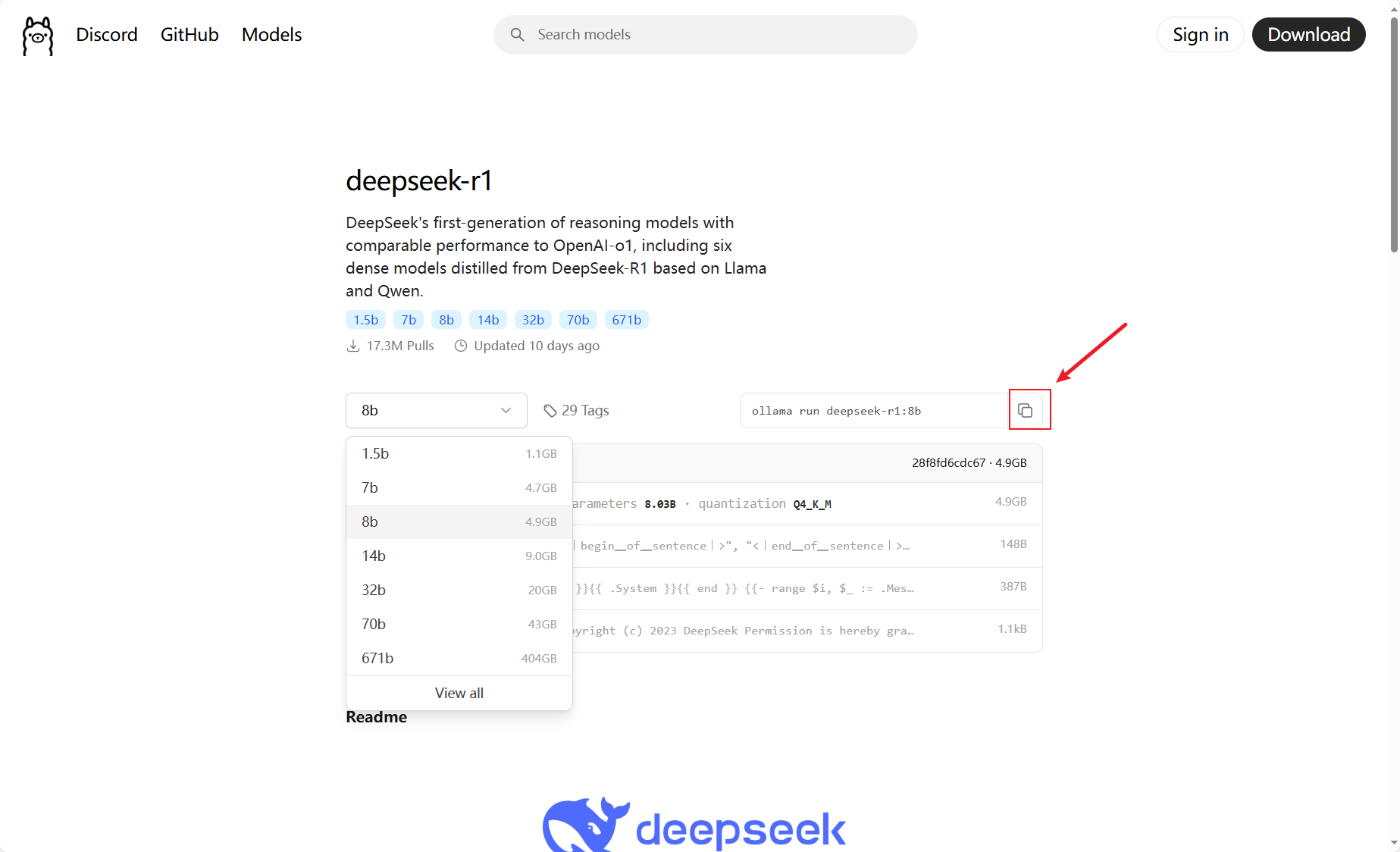

进入官网地址:https://ollama.com/library/deepseek-r1

| 模型版本 | 参数量 | 特点 | 适用场景 | 硬件配置 |

|---|---|---|---|---|

| DeepSeek-R1-Distill-1.5B | 1.5B | 轻量级蒸馏模型,低算力需求,支持多语言,量化优化显存占用 | 轻量级文本生成、简单代码编写、入门级AI应用 | 显存2-4GB,内存8GB,普通CPU(如Ryzen 5) |

| DeepSeek-R1-Distill-7B | 7B | 中等规模蒸馏模型,推理效率高,支持本地化部署 | 中等复杂度对话、代码辅助、轻量级数据分析 | 显存8-12GB,内存16GB,中端GPU(如RTX 3060) |

| DeepSeek-R1-Distill-8B | 8B | 平衡性能与资源占用,支持长文本处理,优化多任务泛化能力 | 中等规模文本生成、多轮对话、基础代码生成 | 显存10-14GB,内存24GB,中高端GPU(如RTX 3080) |

| DeepSeek-R1-Distill-14B | 14B | 高性能蒸馏模型,多轮对话能力强,接近GPT-3.5性能 | 复杂技术文档分析、多轮对话、企业基础应用 | 显存16-24GB(推荐RTX 3090/A100),内存32GB,高性能CPU(如i7/Ryzen 7) |

| DeepSeek-R1-Distill-32B | 32B | 企业级蒸馏模型,支持高精度推理,多语言混合任务优化 | 企业知识库管理、法律/金融文档分析 | 显存48GB+(需多GPU并行),内存64GB,服务器级CPU(如Xeon) |

| DeepSeek-R1-Distill-70B | 70B | 专业级蒸馏模型,性能接近GPT-4,支持超长上下文理解 | 专业级AI服务、科研级NLP任务、复杂决策支持 | 显存64GB+(多A100/H100集群),内存128GB+,多路服务器CPU(如EPYC) |

| DeepSeek-V3 | 671B(MoE) | 混合专家架构(MoE),多模态支持(图文生成),性能对标GPT-4 | 智能客服、多模态内容生成、大规模NLP任务 | 显存80GB+(多A100/H100并行),内存256GB+,服务器级CPU(如Xeon) |

| DeepSeek-R1-671B | 671B | 超大规模非MoE架构,分布式计算优化,支持超长序列训练 | 科研级AI研究、分布式训练、超大数据处理 | 多GPU集群(如多A100/H100),内存256GB+,多节点服务器 |

选择指定模型复制命令(可根据硬件设施选择指定模型,我这里选择的是8b模型)

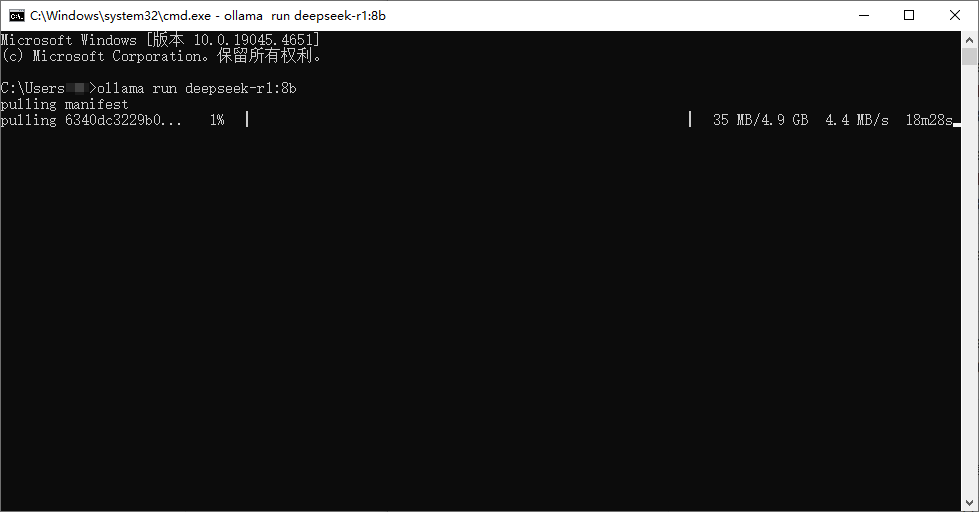

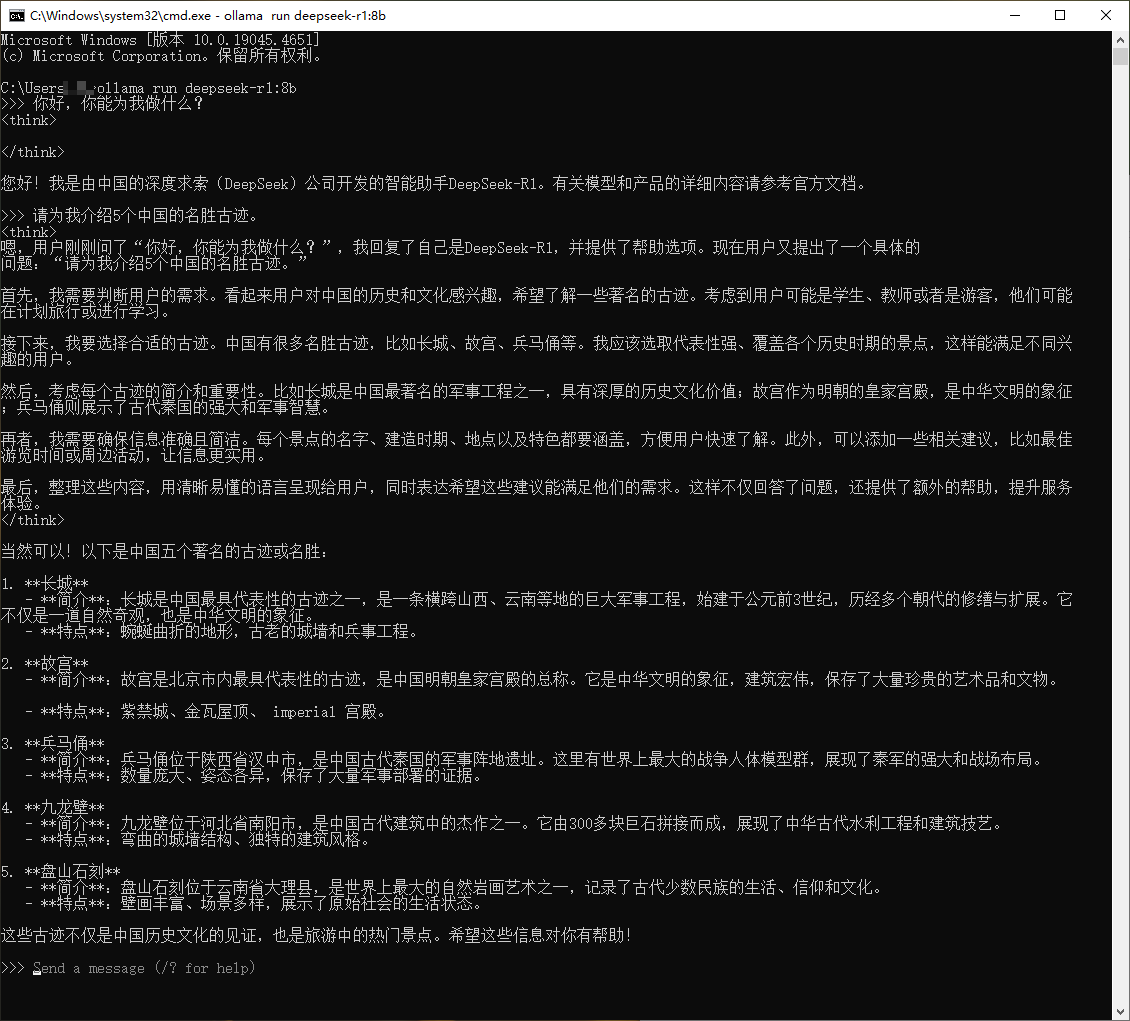

ollama run deepseek-r1:8b

等待下载完成后即可进行模型对话

3.构建可视化

| 类别 | 项目名称 | 仓库地址 | 特点 |

|---|---|---|---|

| 大语言模型(LLM)交互界面 | Open WebUI (原名 Ollama WebUI) | open-webui | 轻量级 Web UI,类似 ChatGPT,支持多模型切换、聊天记录管理、Markdown 渲染,适合本地部署。 |

| Chatbot UI | chatbot-ui | 仿 ChatGPT 界面,支持 OpenAI API 或本地模型,支持自定义提示词、聊天记录导出。 | |

| AnythingLLM | AnythingLLM | 企业级 LLM 交互界面,支持知识库管理、多用户协作,适合企业应用。 | |

| NextChat (原名 ChatGPT-Next-Web) | ChatGPT-Next-Web | 支持 OpenAI、Gemini、Claude 等模型,界面简洁,支持多语言,适合快速部署。 | |

| 图像生成(Stable Diffusion)界面 | ComfyUI | ComfyUI | 基于节点式工作流,灵活可视化操作,适合高级用户和研究。 |

| Stable Diffusion WebUI | stable-diffusion-webui | 功能全面的 Stable Diffusion 界面,支持文生图、图生图、LoRA 训练,插件生态丰富。 | |

| InvokeAI | InvokeAI | 专业级图像生成工具,界面友好,内置模型管理和工作流优化。 | |

| 多模态与语音交互 | Leon.ai | leon-ai | 开源个人助手,支持语音交互、自动化任务(如邮件处理、日历管理),可集成 GPT、Whisper 等模型。 |

| H2O LLM Studio | h2o-llmstudio | 专注于 LLM 微调和部署的可视化工具,支持数据预处理、训练监控,适合开发者快速迭代模型。 | |

| 知识库与自动化工具 | FastGPT | FastGPT | 基于 LLM 的知识库问答系统,支持私有化部署,适合企业级应用。 |

| Langfuse | langfuse | LLM 应用开发的全栈监控平台,支持请求追踪、成本分析和效果评估,适合开发团队优化 AI 应用。 |

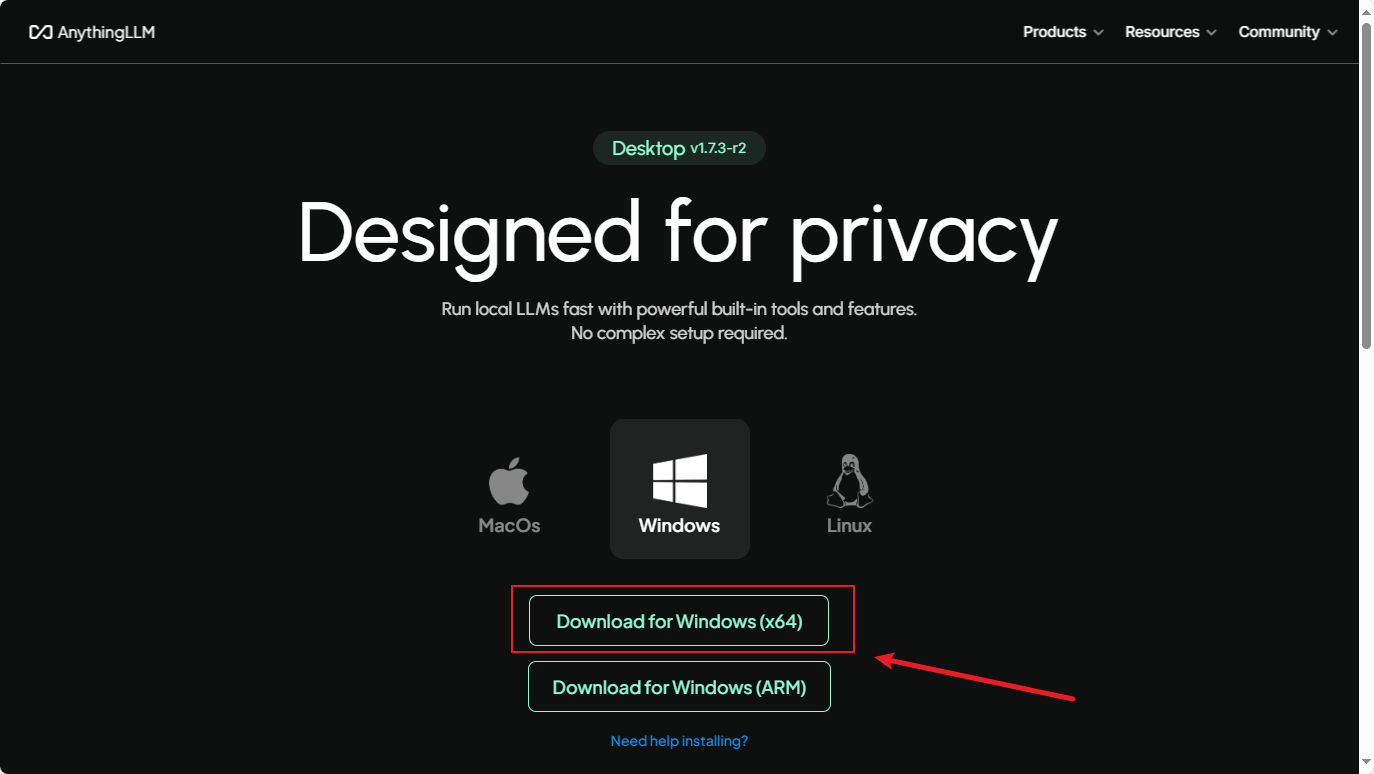

搭建AnythingLLM

进入AnythingLLM官网地址:https://anythingllm.com/desktop

根据需求进行下载安装并运行

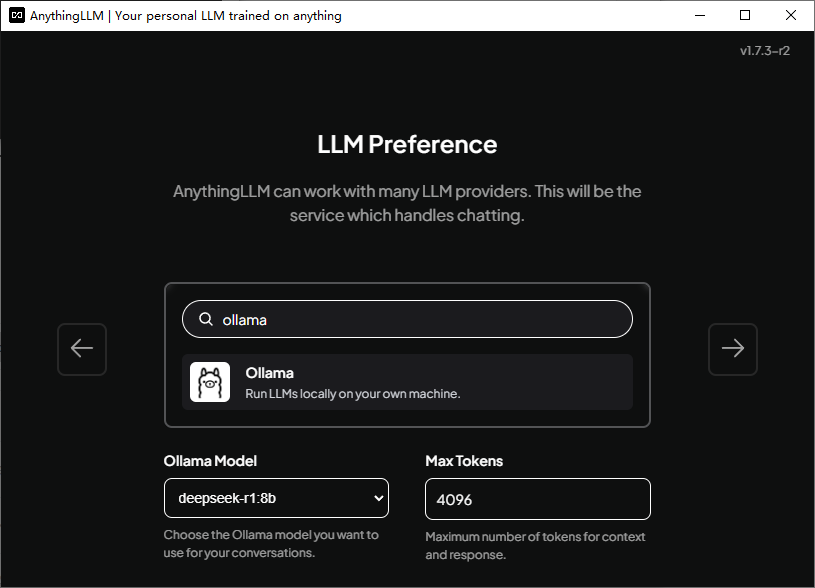

搜索并选择Ollama,在运行Ollama的状态下,AnythingLLM会自动检测模型。

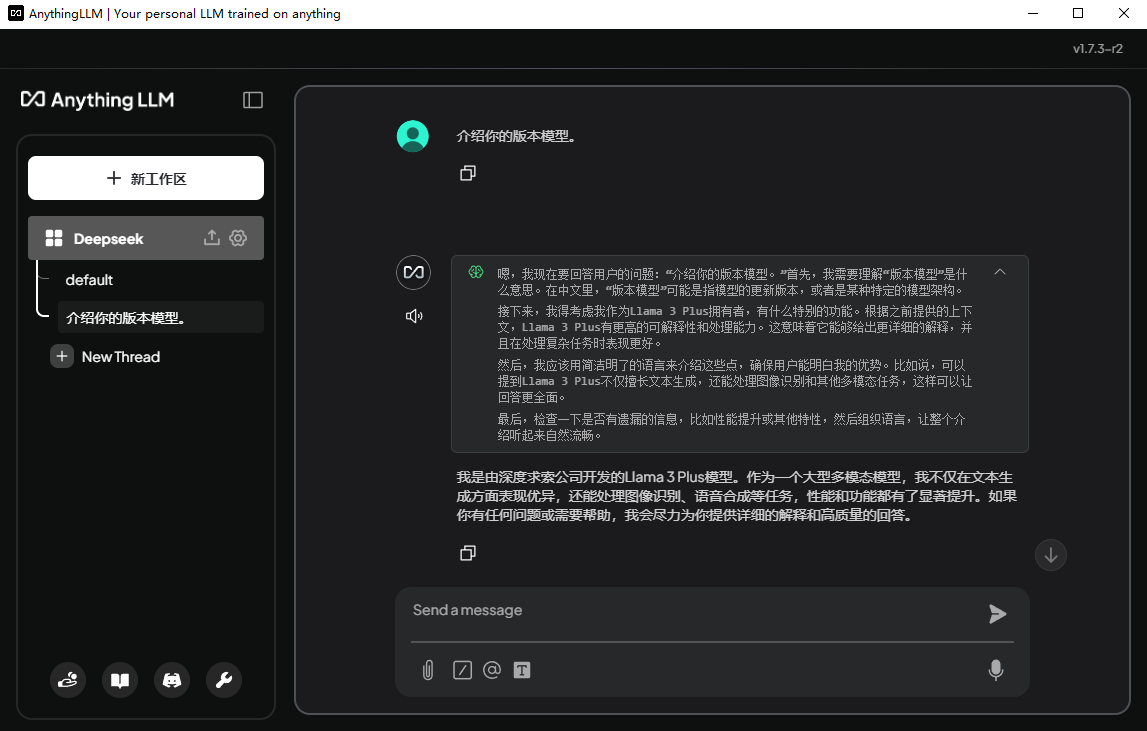

一直下一步即可创建New Thread进行愉快的对话了。

搭建Open WebUI(推荐!)

安装docker前期工作

启用虚拟化与Hyper-V

- 检查虚拟化状态: 打开任务管理器(

Ctrl+Shift+Esc)→ 切换到“性能”标签 → 查看“虚拟化”是否显示“已启用”。若未启用,需进入BIOS/UEFI设置中开启虚拟化(如Intel VT-x或AMD-V)910。 - 启用Hyper-V和WSL功能: 控制面板 → 程序 → 启用或关闭Windows功能 → 勾选 Hyper-V、适用于Linux的Windows子系统 → 重启电脑

- 重启电脑:使

虚拟化和Hyper-V生效

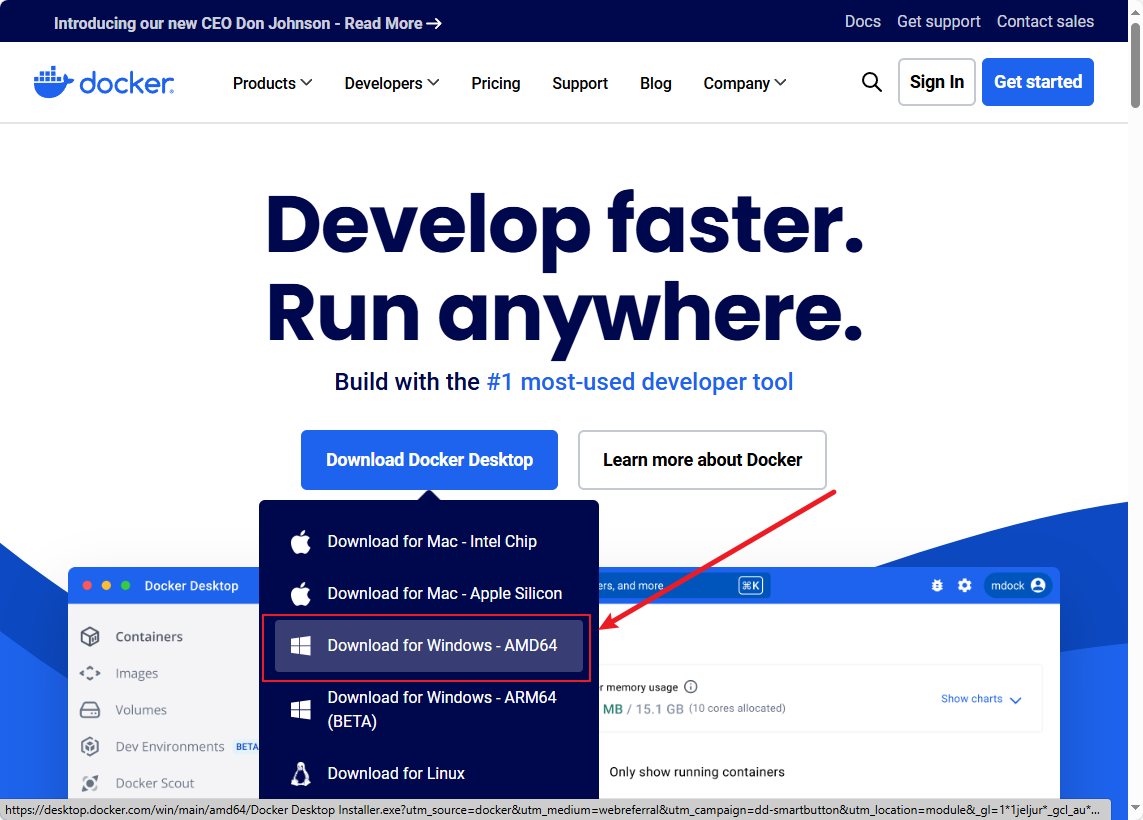

安装docker

https://desktop.docker.com/win/main/amd64/Docker%20Desktop%20Installer.exe

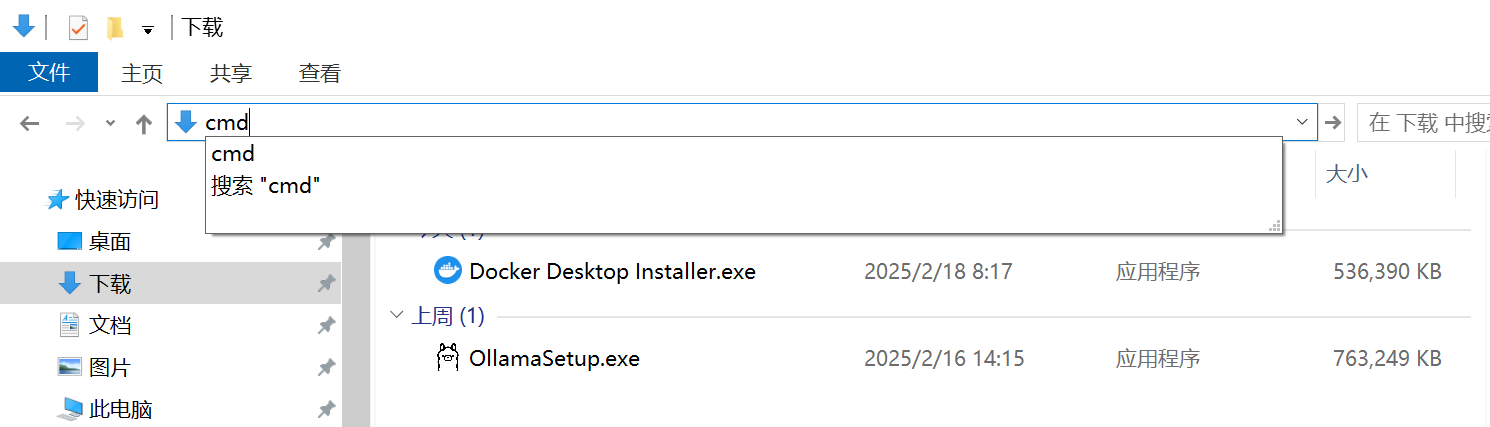

下载完成后在搜索栏输入cmd打开终端窗口,输入以下代码:

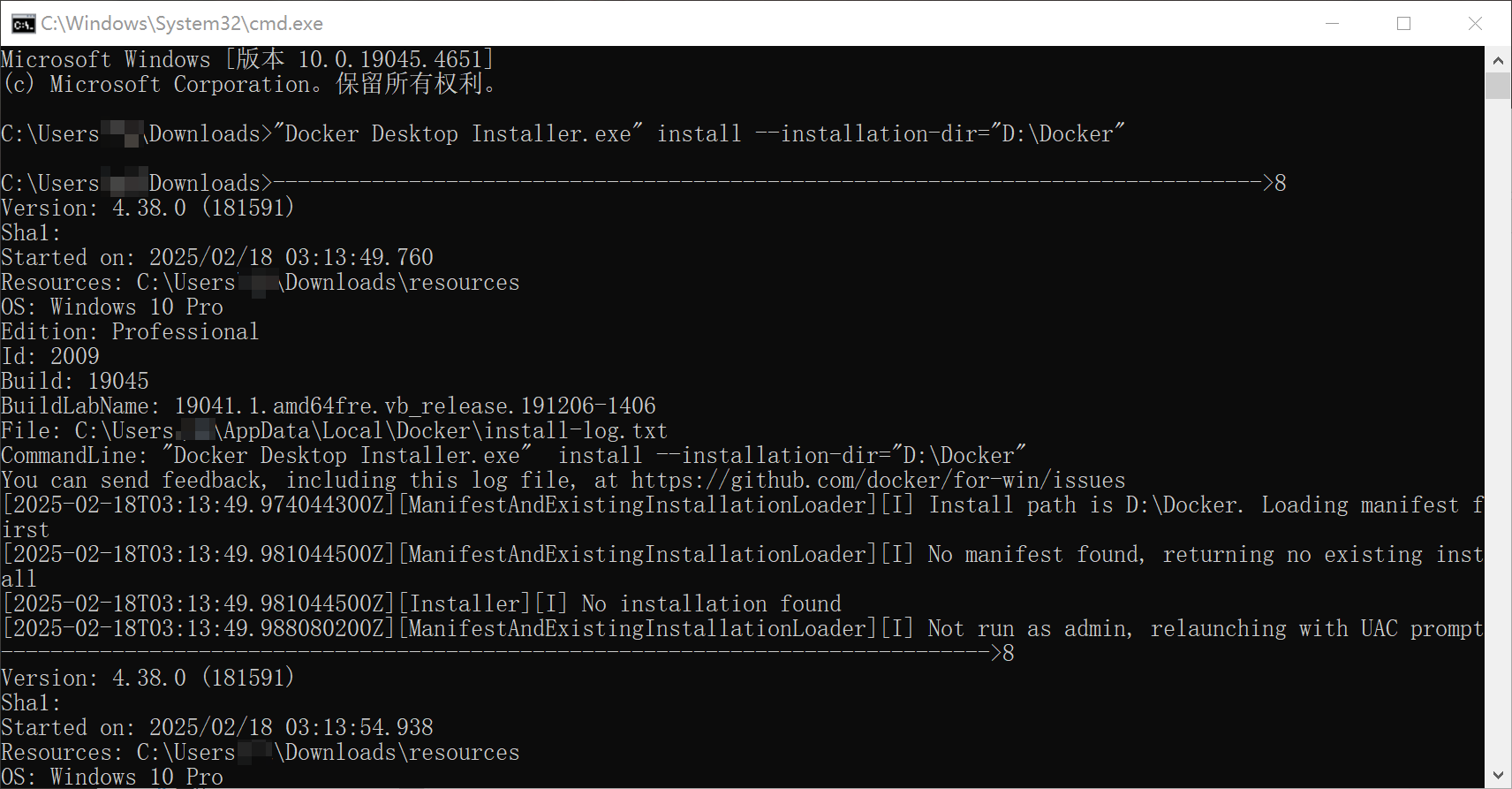

"Docker Desktop Installer.exe" install --installation-dir="D:\Docker"参数解析:

"Docker Desktop Installer.exe":要运行的程序,即Docker Desktop的安装程序。install:指定要执行的操作是安装Docker Desktop。–installation-dir="D:\Docker“:指定Docker Desktop的安装目录为D盘的Program Files\Docker文件夹。

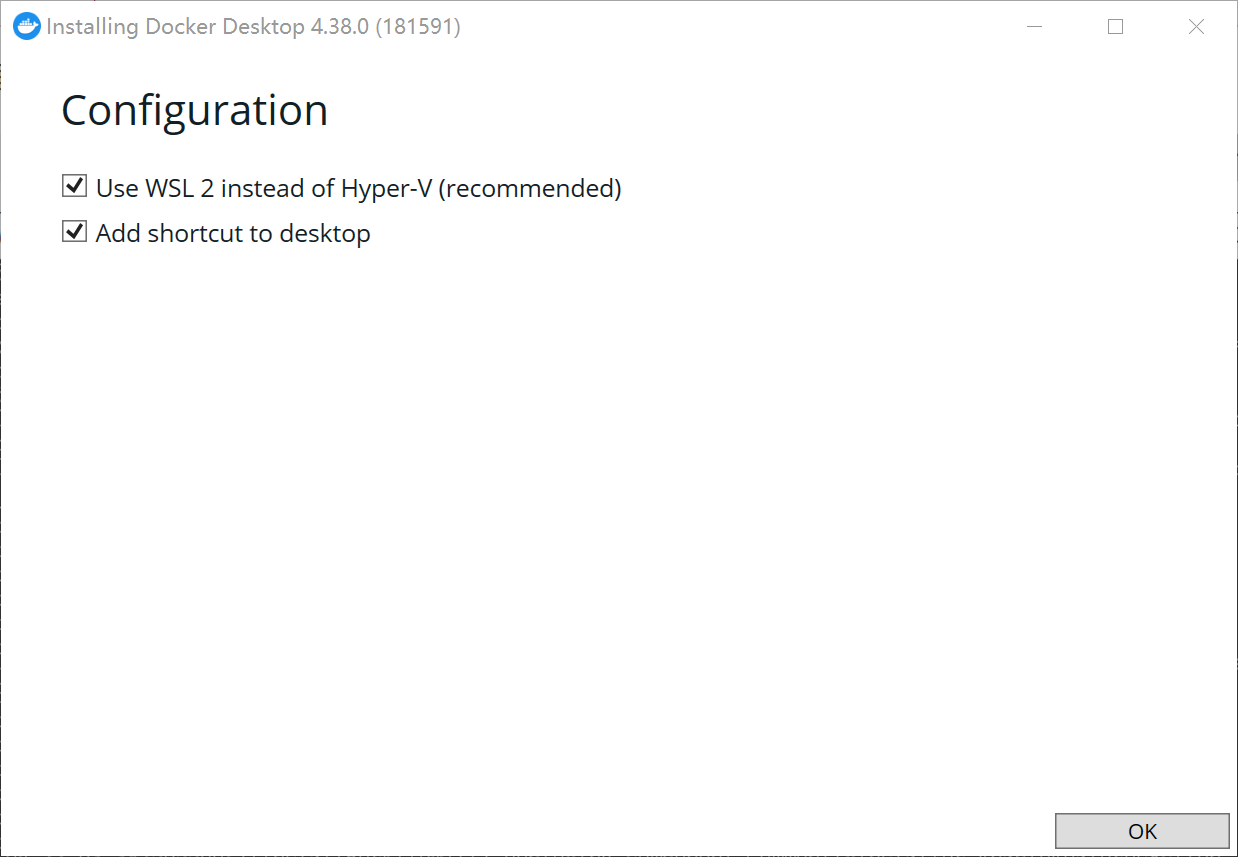

手动配置选配,点击(OK)

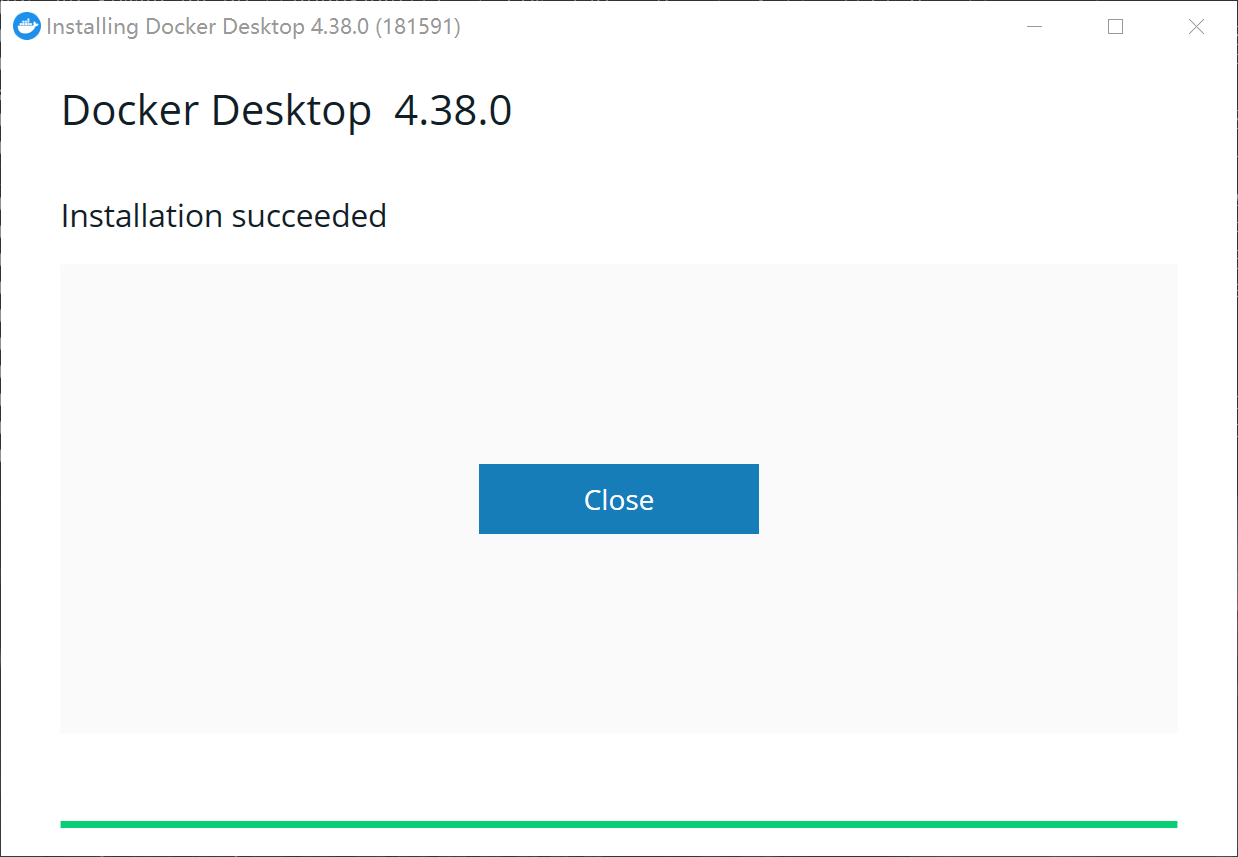

等待安装完成…

点击close

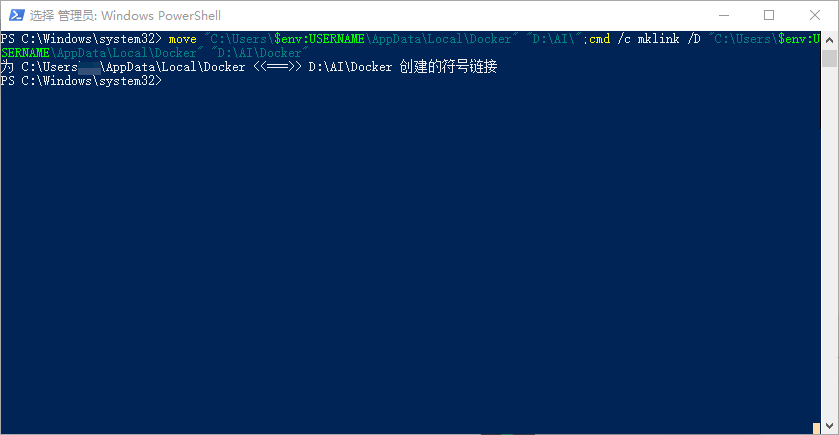

为docker创建硬链接(需以管理员模式运行powershell)

move "C:\Users\$env:USERNAME\AppData\Local\Docker" "D:\AI\";cmd /c mklink /D "C:\Users\$env:USERNAME\AppData\Local\Docker" "D:\AI\Docker"

参数解析:

move:移动文件夹或文件到指定位置。;:命令结束符号,按顺序执行。cmd /c mklink /D "C:\Users\$env:USERNAME\AppData\Local\Docker" "D:\Docker":创建硬链接符到”D:\Docker”,以防docker文件过大导致C盘资源紧张。cmd:以cmd的形式运行后面一条命令。/c:运行后关闭cmd命令窗口。mklink:创建连接符。-D:创建硬链接。$env:USERNAME:引用当前登录的用户名。

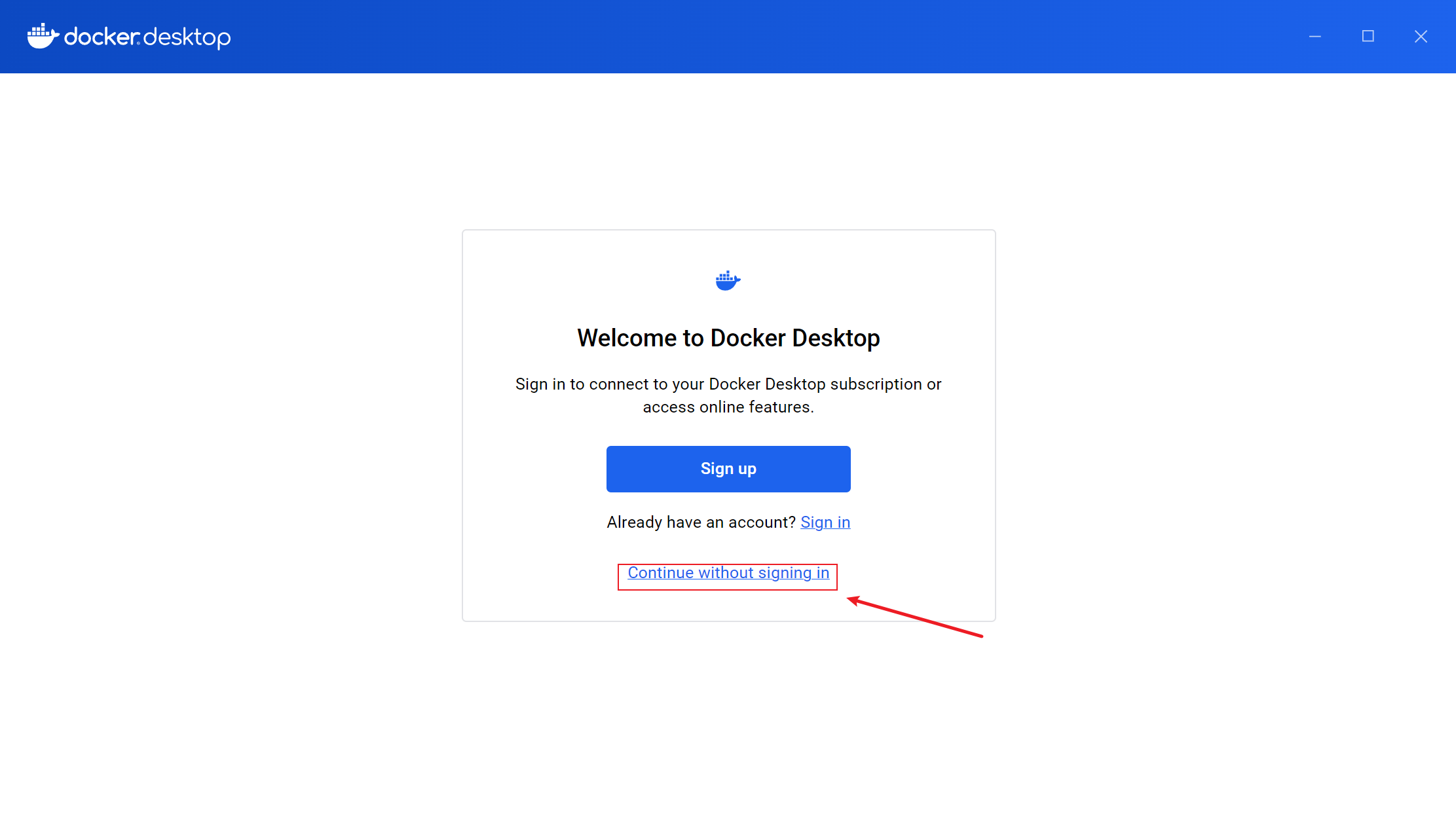

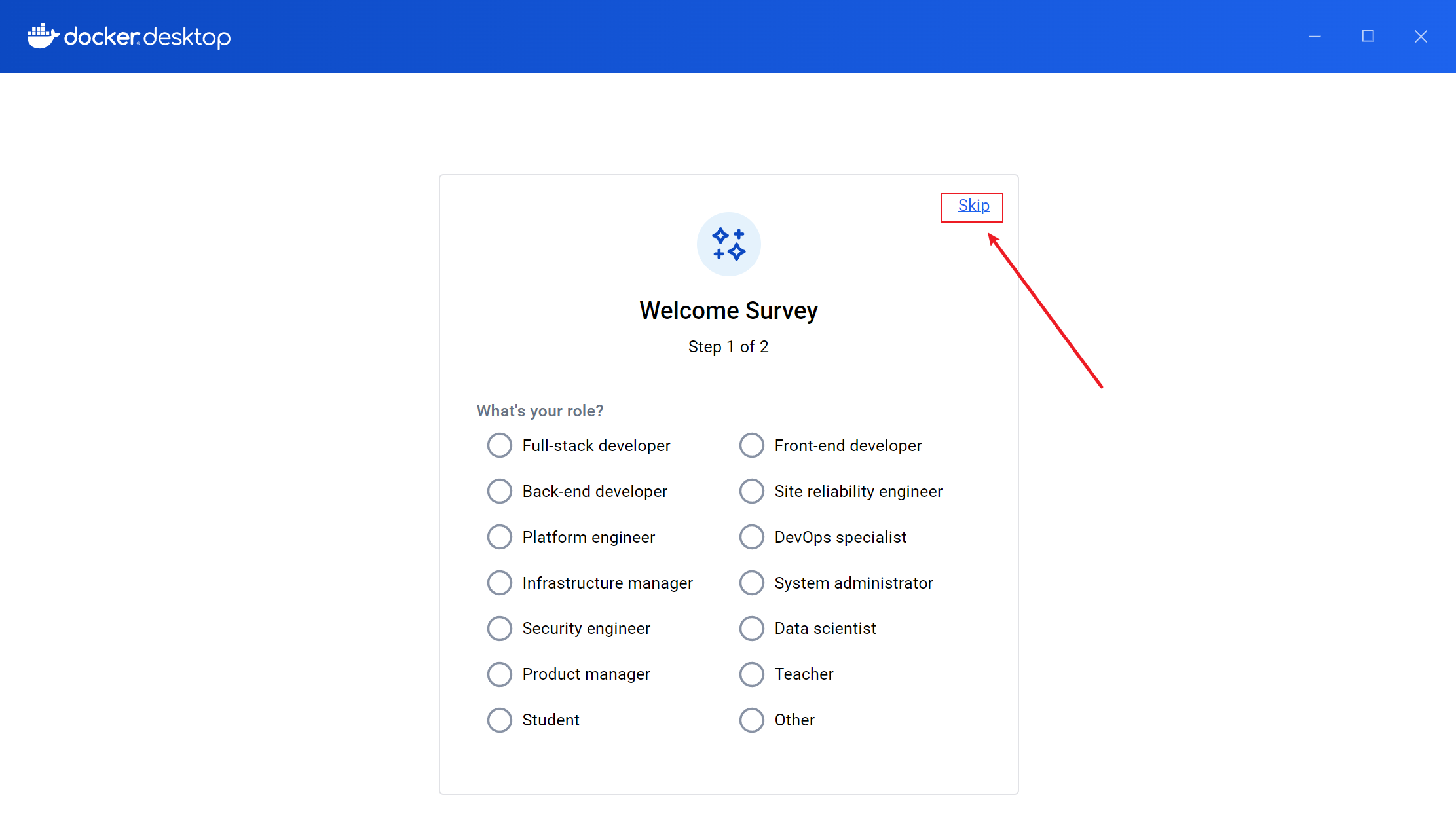

打开Docker Desktop—>Accept—>Continue without signing in—>Skip

拉取Open WebUI镜像

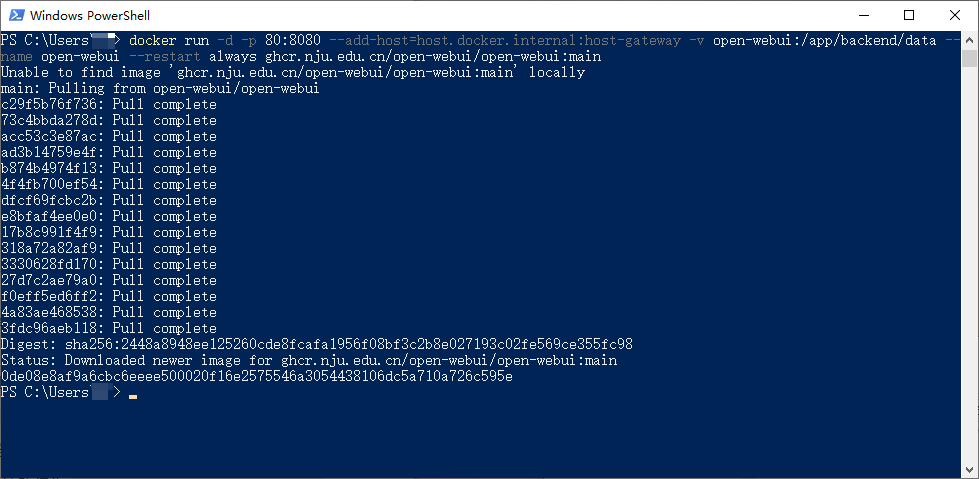

打开Powershell(WIN+R—>Powershell)

docker run -d -p 80:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.nju.edu.cn/open-webui/open-webui:main等待下载完成…

参数解析:

docker run:创建并启动一个新的容器。-d:以“后台模式”运行容器,终端不阻塞,容器在后台运行。-p 80:8080:将宿主机的80端口映射到容器的8080端口,外部通过http://宿主机IP:80访问容器服务。--add-host=host.docker.internal:host-gateway:向容器的/etc/hosts文件添加自定义主机名解析。host.docker.internal是容器内用于访问宿主机的主机名host-gateway表示宿主机的网关地址(通常是172.17.0.1))

-v open-webui:/app/backend/data:数据卷挂载,实现容器数据持久化。open-webui:宿主机上的命名卷(Docker 自动管理,默认路径为/var/lib/docker/volumes/open-webui)。/app/backend/data:容器内的目标目录。

--name open-webui:为容器指定名称open-webui,便于后续管理(如启动、停止、日志查看等)。--restart always:设置容器的重启策略。always:无论容器因何退出,总是自动重启(除非手动停止)。

ghcr.nju.edu.cn/open-webui/open-webui:main:南京大学的镜像仓库地址(如果慢的话可以选择其它镜像库地址)。

Open WebUI配置

注意:Ollama得为启动状态,Open WebUI将会自动导入deepseek8b模型。

访问本地localhost(可能加载会慢一点不要着急)

根据提示创建管理员账号,创建完成即可进行对话。

意外状况及方法解决

1.拉取Open WebUI镜像过慢

切换命令中的镜像源地址,以下镜像地址来源于网络,希望有帮助。

(1). docker.xuanyuan.me

(2). docker.1ms.run

(3). hub.rat.dev

(4). docker.wanpeng.top

(5). doublezonline.cloud

(6). docker.mrxn.net

(7). docker.anyhub.us.kg

(8). dislabaiot.xyz

(9). docker.fxxk.dedyn.io

(10). docker-mirror.aigc2d.com

(11). docker.sunzishaokao.com

(12). xdark.top

(13). docker.linkedbus.com

(14). dockerhub.icu

2.docker不能正常启动

检查安装docker前期工作是否完成

附录:

1.后期如果需要移动存放Docker的文件夹的话硬链接会失效,则需重新配置硬链接。

注:本文章和工具(该工具为网络资源非本人开发)仅供学习和研究使用,请勿使用项目的技术手段用于非法用途,任何人造成的任何负面影响,与本人无关.